Automatizar con IA para liberar tiempo

Así he diseñado un sistema de alertas deportivas sin servidores ni costes, y en 20 minutos.

En el análisis deportivo, la velocidad con la que llega la información define la calidad de la decisión. Los resultados, parciales o finales, condicionan el análisis de rendimiento, la planificación de contenidos y el seguimiento de competiciones. Sin embargo, muchos portales oficiales no ofrecen sistemas de alertas ni APIs públicas que faciliten este flujo. Por eso me propuse resolver un problema concreto: recibir notificaciones automáticas cada vez que se actualizan los resultados de la liga U22 en la web oficial de la Federación Española de Baloncesto, sin depender de servidores, suscripciones o herramientas de pago.

La idea era sencilla: crear un flujo de automatización fiable, mantenible y totalmente en la nube, combinando herramientas gratuitas y abiertas como GitHub Actions, Python y Telegram. El punto de partida fue detectar una necesidad real. La web publica los resultados cada fin de semana, pero no ofrece avisos ni RSS. Revisarla manualmente implica perder tiempo y atención. La solución debía ser igual de simple: un sistema que comprobara periódicamente si los resultados habían cambiado y me avisara automáticamente a mi móvil, sin coste y sin infraestructura propia. Igual que si un colega te mandara un Telegram.

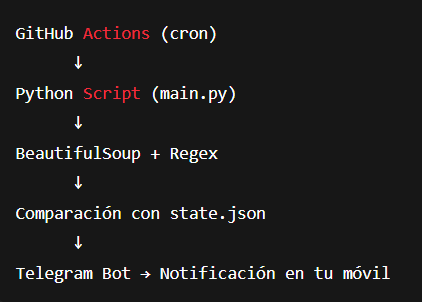

Para lograrlo, elegí herramientas que ya hacen bien su trabajo y las combiné de forma inteligente. Python me permitió extraer y procesar datos web con librerías como requests y BeautifulSoup. Telegram ofrecía una vía gratuita y fiable para recibir notificaciones push en el móvil o escritorio. GitHub Actions se convirtió en el entorno perfecto para ejecutar scripts en la nube de forma programada, sin pagar infraestructura. Como almacenamiento, bastó con un archivo JSON para guardar el estado entre ejecuciones y evitar alertas duplicadas. El objetivo era claro: revisar los resultados cada 30 minutos y avisar solo cuando algo cambie.

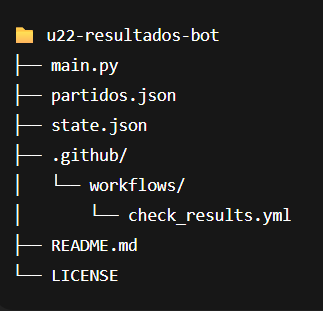

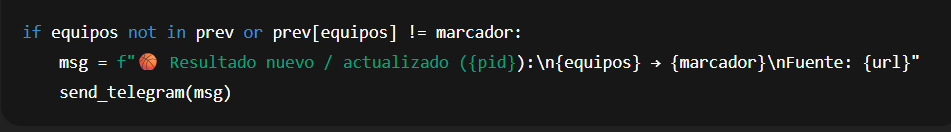

La arquitectura del sistema se apoyó en tres piezas esenciales: un script principal que analiza la web y detecta nuevos resultados, un workflow en GitHub Actions que ejecuta el script periódicamente y un par de archivos auxiliares para guardar el estado y la lista de partidos. El comportamiento es simple: GitHub ejecuta automáticamente el script, este accede a la página de resultados, analiza el HTML y extrae los marcadores. Si detecta un cambio, envía un mensaje a Telegram y actualiza el estado en el repositorio para evitar notificaciones repetidas. Todo ocurre en la nube, sin intervención manual.

El código se mantiene por debajo de las 100 líneas y se centra en tres funciones clave: una para extraer los resultados de la página, otra para compararlos con el estado previo y una tercera para enviar el aviso a Telegram. Cada mensaje incluye el identificador del partido y el enlace directo a la fuente oficial. La simplicidad del diseño permite que sea legible y extensible.

Este enfoque cumple principios esenciales en cualquier automatización moderna: cero infraestructura, seguridad gracias a los secretos del repositorio y escalabilidad sin fricción. Basta añadir más URLs para monitorizar nuevas competiciones. Además, GitHub registra cada ejecución y commit, lo que aporta un histórico natural y trazabilidad.

Por supuesto, el sistema se puede mejorar. Se podría almacenar un histórico en CSV o en una base de datos para generar informes semanales, integrar los datos con Google Sheets o Power BI para análisis visual, crear un dashboard web o incluso aplicar modelos predictivos basados en la evolución de resultados. La arquitectura modular permite añadir estas capas sin cambiar la base. En mi caso, lo que necesitaba era algo sencillo, rápido y fiable. La carga de estadísticas y resultados ya lo gestiono en mi dataset, por lo que, aunque este flujo se puede mejorar y ampliar, prioricé la eficiencia y la tarea básica, de A a B, y ya.

Lo más relevante no es el script en sí, sino la mentalidad que lo impulsa: automatizar tareas repetitivas para liberar tiempo y atención. Cada hora que no se gasta refrescando páginas es una hora más para analizar, crear o decidir. Usar la automatización no siempre implica construir sistemas complejos; a veces basta con unir piezas ya disponibles y dejar que trabajen por nosotros.

En menos de media hora de configuración, este sistema convierte una tarea rutinaria en un proceso autónomo, transparente y gratuito. No hace falta infraestructura, ni APIs oficiales, ni depender de terceros: solo una idea clara y una ejecución ordenada. La automatización, bien entendida, no sustituye el trabajo analítico: lo potencia. Y proyectos como este lo demuestran: la tecnología no compite con el criterio humano, lo amplifica.

Repositorio y código fuente:

👉 Disponible públicamente en GitHub

Licencia: MIT (libre para uso y adaptación).

Tecnologías empleadas: Python · GitHub Actions · Telegram API · BeautifulSoup